Методи та технології інтерпретації моделей машинного навчання

Анотація. У роботі сфокусовано увагу на зростаючій важливості інтерпретації моделі, виокремлено методи, які допомагають пояснити результати прогнозування та підвищити довіру користувачів. Проаналізовано такі основні методи, як метод важливості ознак, який оцінює, як кожна ознака впливає на прогнози моделі; метод перестановочної важливості, який оцінює вплив зміни значень ознак на точність моделі; SHAP (метод пояснення за значенням Шеплі), який обчислює внесок кожної ознаки в прогноз; і теплові карти, які візуально показують важливість різних областей вхідних даних.

Швидкий розвиток методів та технологій машинного навчання в останні роки привів до можливості їхнього застосування для розв’язування все більш широкого круга задач все більш широким колом користувачів. Розроблено багато методів, які доводять точність моделей прогнозування або класифікації і це вважається основним критерієм для використання побудованої моделі на практиці. При цьому розповсюдження використання складних моделей ставить у центр уваги компроміс між точністю та інтерпретованістю вихідних результатів моделі.

Здатність правильно інтерпретувати вихідні дані моделі сприяє відповідному рівню довіри користувачів, дає змогу зрозуміти, як можна покращити модель, а також допомагає краще усвідомити процес, який моделюється. Останнім часом було запропоновано широкий спектр методів для вирішення цієї проблеми [1, 2, 3].

Далі коротко розглянуті основні методи інтерпретації.

- Метод важливості ознак (Feature Importance) оцінює наскільки кожна ознака впливає на прогноз моделі. Залежить від типу моделі.

- Перестановочна важливість (Permutation Importance) базується на припущенні, що якщо ознака є важливою для моделі, її перестановка (тобто випадкова зміна значень цієї ознаки) значно знизить точність прогнозу. Не залежить від типу моделі.

- Метод локальної інтерпретації (Local Interpretation Methods) дозволяє вивчати поведінку складної моделі шляхом апроксимації простішою, зрозумілою моделлю в межах конкретного набору даних. Використовується у глибоких нейромережах та ансамблевих моделях.

- Пояснення за значенням Шеплі (SHAP) — це підхід, заснований на теорії ігор, який використовує Shapley values (значення Шеплі) - це середній граничний внесок значення ознаки у всіх можливих коаліціях з іншими ознаками.

- Ансамблеві методи (Ensemble Interpretation Methods). У випадку ансамблів моделей, таких як Random Forest або XGBoost, ці методи дозволяють інтерпретувати результати, аналізуючи, як окремі моделі ансамблю взаємодіють і як їх результати комбінуються для отримання кінцевого прогнозу.

- Візуалізація нейронних мереж (Neural Network Visualization). Цей підхід використовується для глибоких нейронних мереж, щоб з’ясувати, як нейрони в різних шарах мережі реагують на різні вхідні дані.

Один з цих підходів може бути проілюстрований на прикладі лінійної регресійної моделі, яка пов’язує внутрішній регіональний продукт за областями України з деякими соціально економічними показниками (чисельність населення, міграція, капітальні інвестиції, обсяги сільськогосподарської та промислової продукції, обсяг зовнішньої торговлі, витрати на розвиток науки та освіти та ін). Дані за 2021 р.

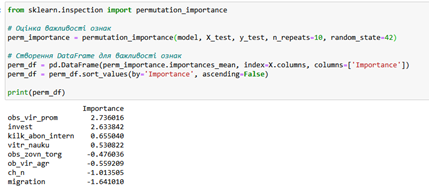

На рис. 1 представлені результати оцінки важливості ознак, отримані за допомогою методу Permutation Importance з Python-бібліотеки sklearn. Ознаки з високим позитивним значенням важливості (наприклад, обсяг виробництва промислової продукції) є важливими для моделі, тобто їх зміна значно знижує точність прогнозів. Ознаки з від’ємними значеннями (наприклад, чисельність населення) мають негативний вплив на точність, тобто їхня відсутність може навіть покращити модель. Це не очевидно, тож дозволяє замислитись над якістю даних або самої моделі і таким чином, з пересторогою відноситись до її використання.

Таким чином, використання методів та програмних технологій інтерпретації це один з шляхів, який доцільно використовувати для покращення результатів застосування моделей машинного навчання.

Література

- Lundberg S. M., Lee S. I. A Unified Approach to Interpreting Model Predictions. 31st Conference on Neural Information Processing Systems (NIPS 2017), Long Beach, CA, USA. 2017.

- Saleem Rabia et al. Explaining Deep Neural Networks: A Survey on the Global Interpretation Methods. Neurocomputing. 2022. Vol. 513. P. 165–180.

- Liang Yu et al. Explaining the Black-Box Model: A Survey of Local Interpretation Methods for Deep Neural Networks. URL: https://www.elsevier.com/open-access/userlicense/1.0/.2.